难倒全球最强计算机视觉模型,ObjectNet 让识别准确率从 90% 下降至 50%

在过去的十年里,对象识别模型取得了长足的进步,但在精度方面,还有很长的路要走。如今的计算机视觉模型已经学会如何准确识别出照片中的对象,甚至能够在某些数据集中获得优于人类的识别表现。但是,这类对象检测系统在真实场景中的表现却仍然不够理想。为了解决上述问题,近日,麻省理工学院和 IBM 组成的联合团队发布了一个最新的对象识别数据集— ObjectNet ,旨在说明机器学习算法与人类之间的性能差距。

MIT 和 IBM 提出最新数据集 ObjectNet

与许多现有的数据集(现有的数据集往往直接提取 Flickr 及其他社交媒体网站上拍摄的照片)不同,ObjectNet 的数据样本是由自由职业者提供的付费照片。照片中的橘子、香蕉和衣服等物体被倾斜在一边,以奇怪的角度拍摄,并展示在杂乱的房间里。即使是能够在 ImageNet 上获得 97%准确率的目前最先进对象检测模型,在“迎战”ObjectNet 时,准确率也会迅猛下降至 50%— 55%。

ObjectNet 有一种新型的视觉数据集,它借鉴了其他科学领域的控制思想。它甚至没有培训集,只提供测试集以加快流程。与其他常规图像数据集相比,ObjectNet 不包含训练图像。大多数数据集将自身素材分为两个部分,分别为模型训练数据,外加性能测试数据。但是,训练集与测试集之间往往具有某种微妙的关联或者说相似之处,在某些情况下无法进行精准的准确性验证。

麻省理工学院计算机科学与人工智能实验室(CSAIL)以及人脑、意识与机器中心(CBMM)研究科学家 Boris Katz 介绍,整个数据集从设计构思、标准纪数据收入流程外加应用程序开发,总共耗费了三年时间。

研究合著者,麻省理工学院电气工程与计算机科学系研究生 David Mayo 表示,“以偏见受控为前提收集数据是一项相当棘手的工作。我们还得不断进行实验,确保我们提供的指示清晰明了,足以引导拍摄者们正确完成拍摄。”

摆在前面的一个根本性难题是,很少有人愿意分享符合 ObjectNet 要求的照片。为此,研究团队通过 Amazon Mechanical Turk 雇佣了多位自由职业者,这些自由职业者会从应用程序上收到分配的任务,诸如,收到的“动画说明”会告诉他们如何分配物品的摆放位置、拍摄的角度,以及是否将对象摆放在厨房、浴室、卧室、客厅等。在 ObjectNet 中收集的图像有意地在新的背景上显示来自不同视角的对象(物体)。

通过这种方式,研究人员希望消除三种常见的偏见:正面朝上、在相对统一的位置展示核心对象,以及在相对统一的背景下展示核心对象——比如厨房里堆起的杯盘。

研究论文联合作者,CSAIL 与 CBMM 研究员 Andrei Barbu 指出,如果希望了解某种算法在现实世界中的表现,最好是利用无偏见且模型以往从未见过的图像进行测试。

数据的实际收集又额外耗费了一年。在数据收集最开始的一年里,因为不满足要求,这些自由职业者提供的照片中有一半不得不被丢弃。一些“错误”包括,照片被人为加上了标签,变幻背景或者调整角度等。

对象识别仍是一个未被攻克的难题

ObjectNet 建立在今年早些时候由 Facebook AI 研究人员发布的一项研究的基础上,该研究发现,识别家用物品的计算机视觉通常更适合高收入家庭的人。结果显示,六种受欢迎的系统对最富裕家庭的(物品)识别效果比对最贫穷家庭的识别效果好 10% 到 20%,且相较北美和欧洲,它们更容易识别北美和欧洲家庭中的物品。

深度学习利用人工“神经元”层从大规模原始数据当中寻找模式。在利用数百甚至数千个示例完成训练之后,深度学习模型即可学会从照片中识别出椅子等物体。但,即使是包含数百万张图像的原有数据集,也不可能从各个角度及方向展示对象的全貌。正因为如此,深度学习模型在现实场景的对象识别当中才会引发种种问题。

“我们创建这套数据集的目的,在于提醒大家对象识别仍是个未被攻克的难题“, Katz 表示。据悉,Katz 和他的同事们将在今年 12 月 8 日 -14 日举行的神经信息处理系统大会(NeurIPS)上公布 ObjectNet 项目及其主要成果。

Venturebea 的文章评论称,MIT 和 IBM 提出的 ObjectNet 表明人工智能在现实世界中的对象检测方面仍“苦苦挣扎”。

Object Net VS ImageNet

Object Net 数据集以众包照片数据库 ImageNet 为基础。其样本量为 50,000 个图像测试集,测试集大小与 ImageNet 基本持平,具有旋转、背景和视点控制等高级功能。它有 313 个对象类和 113 个重叠的 ImageNet。

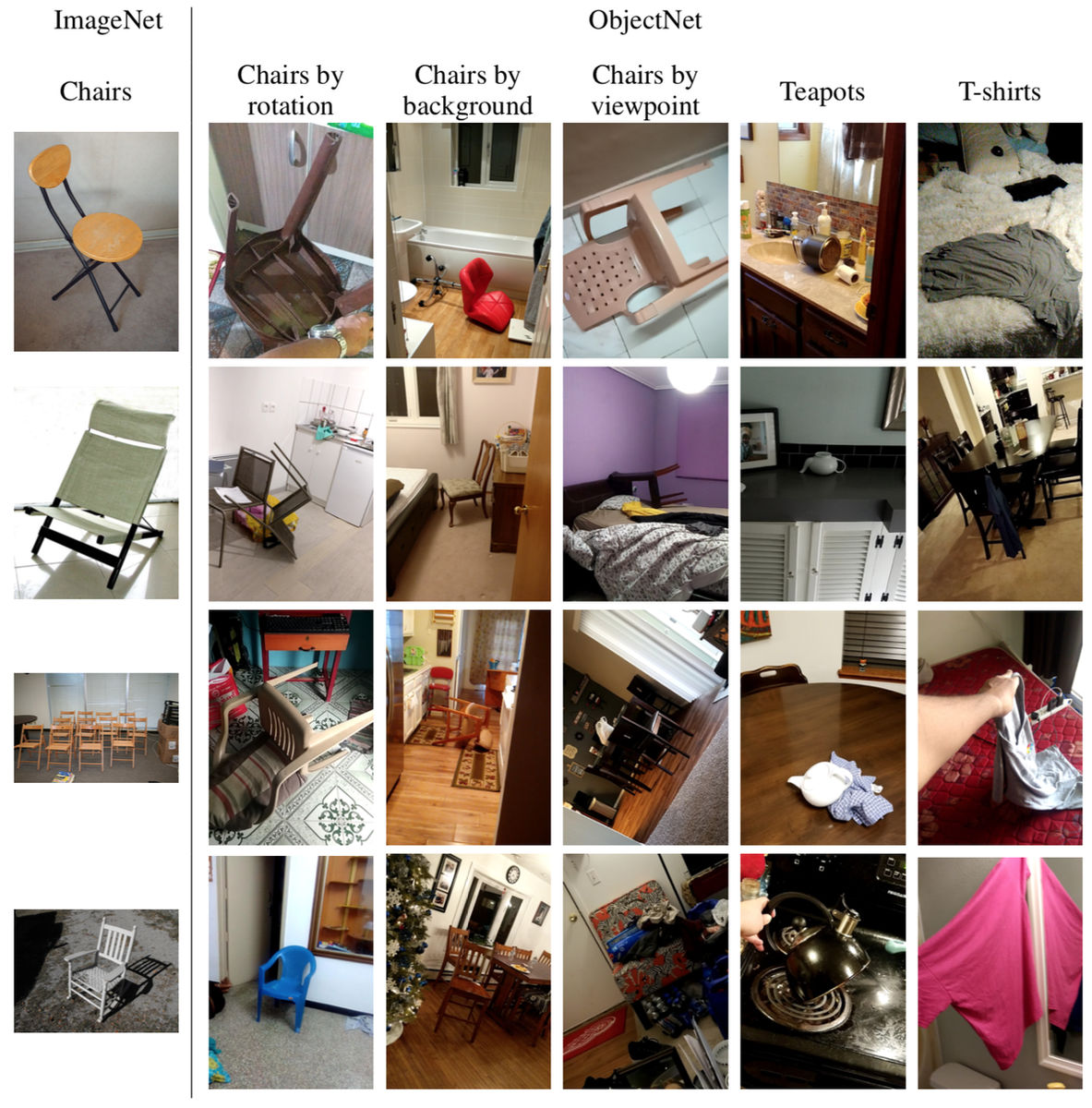

下图,在 ImageNet(左) 中,只记录了以下易于理解的照片。另一方面,在 ObjectNet 中 (右图),一张椅子被放置在一个杂乱的房间中,椅子的背面被拍照,或者是一张人类难以判断的照片。

图像识别模型利用数据集通过深度学习来提高图像识别精度。然而,即使是在 ImageNet 这样的大型数据集中,所包含的图像也存在盲点,即不存在像上面例子中那样的“椅背”或“椅子倒了”的图像。因此,使用 ImageNet 等传统数据集学习的图像识别模型在遇到“椅背”或“倒椅子”等不规则情况时,无法准确识别图像。

在具体的识别成绩方面,研究人员们在 ObjectNet 上测试各类先进计算机视觉模型发现最终成绩相较于 ImageNet 下降了 40%到 45%。研究人员表示,从结果来看,物体检测器仍然未能理解物体的三维属性,特别是能够在新环境下旋转并移动这一前提性事实。研究论文合著者、IBM 公司研究员 Dan GUtfreund 也提到,“现代物体检测器在架构层面并没有引入这些基本概念。”

为了证明 ObjectNet 数据集的识别成绩下滑确实来自对特定对象的观看角度与入镜方式,研究人员允许模型训练 ObjectNet 中一半的数据,然后再对其余的一半进行测试。这种做法往往会提高性能。但 ObjectNet 用事实证明,这种办法在它身上仍然行不通。模型性能只是稍有改善,这表明对象检测器尚未完全理解物体在现实世界中的存在方式。

但研究人员们指出,进一步提升 ObjectNet 的体量以及增加视角与方向等因素的数量,并不一定能带来更好的结果。ObjectNet 项目的目标,在于激励研究人员们开发出下一波革命性技术。

“人们为这些检测器提供越来越多的数据,但收益却在逐渐降低。我们不可能在任意构图形式下,结合任意背景通过任意角度观察对象“。Katz 表示,”我们希望这套新的数据集能够催生出更强大的计算机视觉,以确保它们不会在现实世界中犯下令人难以理解的错误。”

论文: https : //objectnet.dev/objectnet-a-large-scale-bias-control-dataset-for-pushing-the-limits-of-object-recognition-models.pdf

下载数据集: https : //objectnet.dev/download.html

API: https : //github.com/dmayo/ObjectNet-API